Motion Tracker

Tenga en cuenta el entorno especial para Motion Tracker layout (en la parte superior derecha en el menú Entorno), que contiene todos los comandos y vistas importantes.

¿Qué es el trackeado de movimiento?

El trackeado de movimiento - también conocido como ,match moving’ o ,camera tracking’ - es la reconstrucción de la cámara en una grabación original (posición, orientación, longitud focal) basado en un vídeo, es decir, los objetos 3D son colocados en un footage (vídeo) en vivo coincidiendo con la posición, orientación, escala y movimiento del footage original.

Por ejemplo, si tienes footage original en el que deseas colocar un objeto para renderizado, el footage debe ser analizado correctamente y el escenario 3D (la cámara de grabación en sí, así como puntos distintivos con sus posiciones en el espacio tridimensional) debe ser reconstruido, por lo que la perspectiva y todos los movimientos de cámara se ajustan con precisión.

La función Objeto Tracker puede ser visto como una función Motion Tracker. Información detallada se puede encontrar en Objeto Tracker.

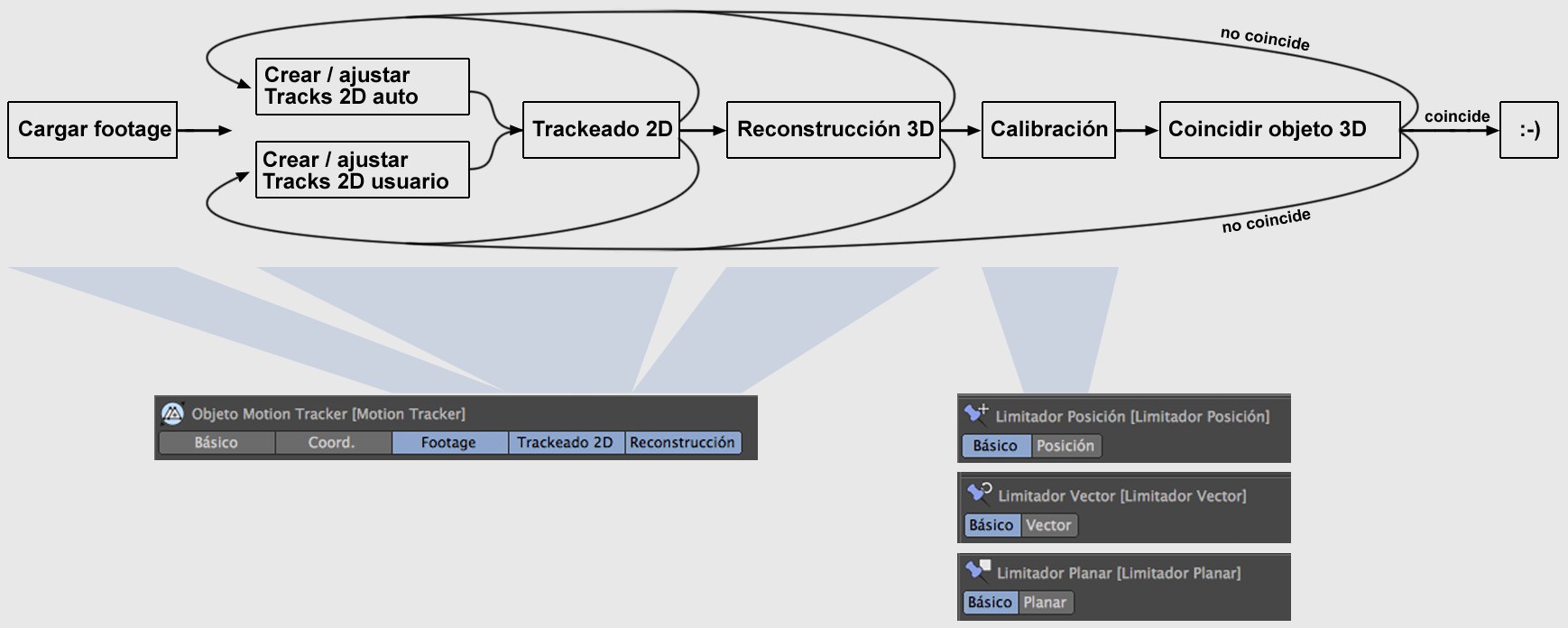

Este es un proceso complejo y, por tanto, debe ser completado en varios pasos:

- Particularmente, los puntos a seguir (denominados Tracks) deben ser fáciles de rastrear en el footage y en sus movimientos siguientes. Esto se puede hacer automáticamente, manualmente o como una combinación de ambos, y se llama Trackeado 2D.

- Usando estos Tracks, los más representativos, se creará una nube espacial de puntos (consistente en Componentes) y se reconstruirán los parámetros de la cámara.

- Pueden usarse varias etiquetas de ayuda (etiquetas Limitadores) para calibrar el Proyecto, es decir, el grupo de puntos más o menos desorientados en el espacio 3D (por supuesto, incluyendo la cámara claramente definida) serán orientados de acuerdo al sistema de coordenadas globales.

La función Calibrador de Cámara no tiene nada que ver con el Motion Tracking. Sin embargo, se puede utilizar para determinar la longitud focal de la cámara con la que se filmó el video (que a su vez ayudará para la resolver la cámara 3D).

En resumen: ¿Cómo funciona Motion Tracker?

Motion Tracker se basa en el análisis y trackeado de los puntos marcados (Tracks) en el footge original. Las posiciones en el espacio 3D se pueden calcular en base a las diferentes velocidades con las que estos Tracks se mueven en función de su distancia a cámara (este efecto se conoce como parallax scrolling (desplazamiento de paralaje)).

Movimiento horizontal de cámara de izquierda a derecha.

Movimiento horizontal de cámara de izquierda a derecha.Observa la diferencia entre el footage 1 y 2 en la imagen de arriba. La cámara se mueve horizontalmente de izquierda a derecha. El florero rojo en la parte trasera parece moverse una distancia más corta (longitud de la flecha) que el jarrón azul. Estas diferencias entre los paralajes se pueden utilizar para definir una ubicación correspondiente en el espacio 3D (de aquí en adelante referido como Track) con respecto a la cámara.

Lógicamente, el Motion Tracking se hace más fácil si el footage contiene varios paralajes, es decir, regiones con diferentes velocidades de desplazamiento de paralaje debido a su distancia de la cámara.

Imagina que tienes footage de un vuelo sobre una ciudad con una gran cantidad de rascacielos: un escenario perfecto para Motion Tracking en Cinema 4D con edificios claramente separados, calles en una cuadrícula y contornos claramente definidos.

Los espacios abiertos o panoramas nodales (la cámara gira en el lugar), por el contrario, son mucho más difíciles de analizar debido a que el primero carece de puntos distintivos de referencia y este último no ofrece paralajes. A continuación, debes seleccionar un Modo Resolver específico en la pestaña Reconstrucción para definir qué tipo de Motion Tracking debería tener lugar.

Flujo de trabajo de Motion Tracking para trackeado de cámara

Flujo de trabajo simplificado de Motion Tracking.

Flujo de trabajo simplificado de Motion Tracking.Proceder como sigue si quieres reconstruir la cámara usando una secuencia de video:

- En el menú principal: Selecciona

y selecciona el footage que quieras resolver. El flujo de trabajo en la imagen superior ahora se llevará a cabo hasta el final, incluyendo la reconstrucción 3D. - Todo irá bien si Resolver Diferido Finalizado aparece en la barra de estado (ver también Reconstrucción 3D). Ahora utiliza las Etiquetas Limitadores para calibrar la reconstrucción 3D, haz una prueba de render para comprobar de que todo está correcto. Si no es así, los Tracks 2D deben retocarse (ver ¿Cuáles son los Tracks buenos y malos?) y luego la reconstrucción y calibrado debe repetirse.

- Si la barra estado muestra un mensaje diferente a Resolver Diferido Finalizado se debe pasar directamente a retocar los Tracks 2D (ver ¿Cuáles son los Tracks buenos y malos?) y luego repetir la reconstrucción y calibrado hasta que la reconstrucción 3D se haya realizado correctamente.

Esta es una representación simplificada del flujo de trabajo. Por supuesto que reconstrucciones erróneas pueden darse si seleccionas mal el Modo Resolver o si se define una incorrecta Longitud Focal / Ancho de Apertura en el objeto Motion Tracker (pestaña Reconstrucción). Sin embargo, lo más importante, y también la que consume más tiempo, es el trabajo de retocado de los Tracks 2D.

Una secuencia de vídeo puede verse afectada por una distorsión de lente más pronunciada (líneas realmente recta aparecerán curvadas; ejemplo exagerado: el efecto ojo de pez), dependiendo de la cámara de grabación utilizada. Si este efecto es demasiado pronunciado o incluso si el Motion Tracker falla debido a esto, puede ser que sea necesario crear un perfil de lente mediante la Herramienta Distorsión de Lente y cargarlo aquí.

Sólo hay una manera de comprobar si el proceso se ha realizado correctamente. Y es al final, cuando veas o no que los objetos 3D añadidos al footage parecen realistas, es decir, si no saltan o se mueven de forma poco natural.

Si este no es el caso, es muy probable que tengas que ajustar o crear los Tracks 2D de nuevo. Puedes modificar algunas opciones de configuración, pero el Motion Tracking depende en gran medida de la calidad de los Tracks. El Motion Tracker ofrece toda la ayuda posible con su función Auto Track, pero al final tú tendrás que juzgar por ti mismo qué Tracks son buenos y cuáles son malos - y la cantidad de los nuevos Tracks que tendrás que crear tú mismo (véase también ¿Qué Tracks son buenos y cuáles malos?).

Ten en cuenta que existe un diseño de entorno especial para el Motion Tracker. Se puede seleccionar en el menú desplegable Entorno en la parte superior derecha de la interfaz gráfica.

Ejemplo de configuración de Proyecto

Después de crear con éxito una reconstrucción de cámara, los objetos tendrán que ser colocados correctamente y estar equipados con las etiquetas correctas.

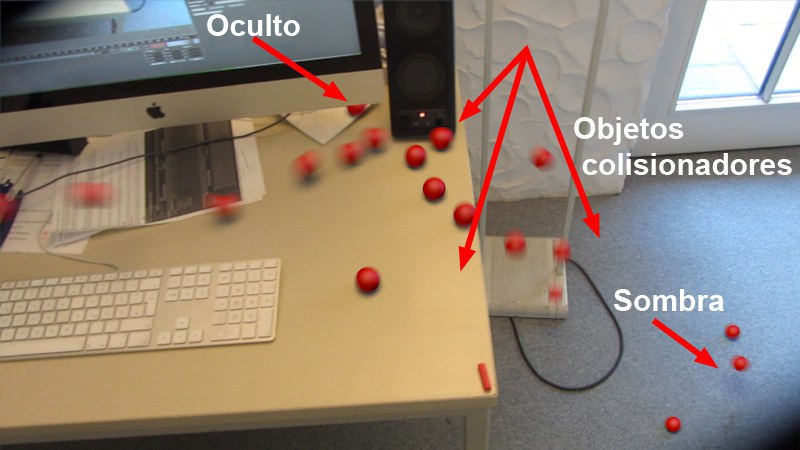

Una invasión de esferas rojas.

Una invasión de esferas rojas.En este ejemplo, un Emisor lanza esferas sobre una mesa que ruedan sobre el borde de la mesa, chocan con el altavoz y caen al suelo. Esta escena utiliza objetos proxy (invisibles!) que sirven como objetos de colisión Dinámicos y, en el caso del monitor, ocultar las esferas detrás de él:

Muy sencillo, objetos proxy colocados eficientemente se utilizan para generar sombras y colisiones correctas.

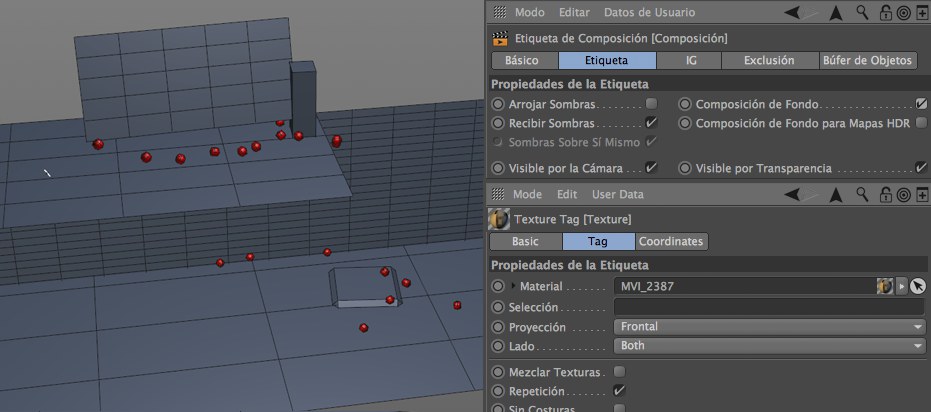

Muy sencillo, objetos proxy colocados eficientemente se utilizan para generar sombras y colisiones correctas.Cada plano ha sido orientado usando la función Crear Plano de la etiqueta Limitador Planar (sin embargo, el Lápiz Polígonos es perfectamente adecuado para esto; activa la función Fijación y habilita ![]() Fijación 3D

Fijación 3D![]() Fijación Ejes

Fijación Ejes

- Etiqueta Composición con Composición de Fondo activado y Arrojar Sombras desactivado.

- Etiqueta textura con el footage ajustado a Proyección Frontal.

- Una etiqueta de Cuerpo Rígido, si es necesaria, para definir el objeto como colisionador.

Como resultado de estos ajustes, los objetos proxy no son visibles para el renderizado, a excepción de las sombras (por supuesto las fuentes de luz tienen que ser creadas y posicionadas correctamente para las sombras).